近期,实验室博士生李亚琼作为第一作者的论文“DeMod: A Holistic Tool with Explainable Detection and Personalized Modification for Toxicity Censorship”被The ACM Conference on Computer-Supported Cooperative Work and Social Computing (CSCW) 会议录用。面对在线社区毒性内容审查,用户有多样性的需求,如结果理解和内容修改等。针对这一问题,我们进行了形成性研究,调查社交用户对毒性内容审查的不同需求及相应的设计期望,并构建了基于ChatGPT的审查工具DeMod。DeMod具有可解释性检测和个性化修改功能,可以向社交用户提供毒性内容的细粒度检测结果、详细的结果解释和个性化修改建议。最后,自动评估和人类评估相结合的验证结果表明了DeMod在功能丰富性、审查准确性和工具易用性等方面的优势。基于这些发现,我们进一步提出了对未来内容审查系统设计的见解。

期刊简介

The ACM Conference on Computer-Supported Cooperative Work and Social Computing (CSCW) 会议是人机交互与普适计算方向的权威国际学术会议(CCF A类推荐国际会议),涵盖了计算机网络与通信技术、多媒体技术、社会学、心理学、管理科学等多门学科的综合应用,在人机交互领域享有很高的学术声誉。该会议计划于2025年10月18日至10月22日在挪威卑尔根召开。

论文简介

DeMod:具备可解释检测和个性化修复的毒性内容审查工具

如今,社交媒体已成为用户自我披露的热门平台,如数亿人每天通Twitter、Facebook和微博记录生活、表达观点、与朋友互动。尽管社交媒体的开放性为内容分享提供了广阔空间,也导致了毒性内容的披露。所谓毒性内容,是指“可能导致他人退出讨论的粗鲁、不尊重或不合理的评论”,包括仇恨言论、骚扰、侮辱及虐待和攻击性言论等。由于语境崩塌现象,用户通常未意识到自己正在披露毒性内容。研究发现,约三分之二的毒性内容属于隐性毒性,而用户往往对这些言论产生的伤害并不自知。另有研究表明,23.00%的用户在回顾自己发布的内容时感到后悔,原因包括未考虑后果、文化误判、意外受众和平台规范误解等。为避免毒性内容披露,社交媒体用户通常在发布前进行审查,如自我审查或借助自动化工具等方式。研究发现,社交用户常通过检查、调整或删除部分内容来确保其适合发布。尽管已有多种毒性内容审查方法,但是绝大多数聚焦于检测毒性内容,如使用Perspective API 评估毒性分数或使用RECAST工具识别毒性关键词。然而,毒性内容审查是一个复杂过程,检测只是一个初步的任务,社交用户可能需要理解检测结果和修改内容。例如,尽管RECAST工具能帮助用户识别毒性词汇,但用户常因知识或经验不足,不知如何降低其毒性。因此,需要一个整体的自动化工具,帮助用户完成毒性内容检测、内容修改等多项审查任务。

构建一个整体性毒性内容审查工具面临诸多挑战。首先,社交用户对毒性内容审查的多样化需求尚不明确。正如前述,用户可能对工具有不同功能要求,如提供丰富的解释和修改建议。因此,在研究毒性内容审查工具时,需系统调查用户的审查需求;其次,设计和实现一个符合社交用户整体性需求的毒性审查工具并非易事。该工具应具备多重目标,如提供精准检测、细粒度结果和个性化修改,如何实现不同功能并高效整合是一个巨大挑战。第三,面向这一多功能的毒性内容审查工具的实际评估较为困难。为了验证工具在帮助社交用户审查毒性内容方面的表现,需在真实社交媒体场景中进行长期评估,而且像个性化修改等效果缺少量化的检测指标,难以评估。

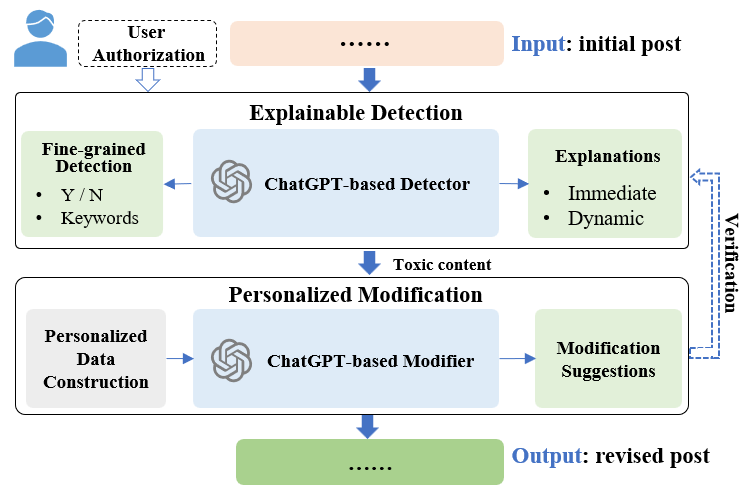

针对上述问题与挑战,我们设计了一个帮助社交媒体用户进行毒性内容审查的工具DeMod,具备可解释检测和个性化修改等多功能。首先,我们在中国流行的社交平台——微博上进行需求调研,通过问卷调查和访谈,我们揭示了社交用户的毒性内容审查实践、遇到的问题以及对毒性内容审查工具的设计期望,并提出五个设计目标:提供整体性审查、提供细粒度检测结果、增强可解释性、给予个性化修改建议、确保用户控制权。其次,基于五项目标,我们设计并实现了一个名为DeMod的整体性自动化毒性内容审查工具,如下图所示。DeMod本质是一个基于ChatGPT增强的内容审查工具,配备了可解释检测器(Explainable Detector)和个性化修改器(Personalized Modifier)模块。可解释检测器提供即时解释(Immediate Explanation)和动态解释(Dynamic Explanation)结果。即时解释通过关键词或毒性原因向用户提供说明当前检测内容为何具有毒性,动态解释则通过模拟受众对即将发布的内容的态度,帮助社交用户了解当前内容的潜在影响。两种解释旨在增强社交用户对毒性内容的理解,进而促使用户的发布前审查和自我调节行为。在此之后,个性化修改器根据社交用户的多重需求提供修改建议,包括去除毒性、保留原意、以及体现用户的个性化语言风格。通过这些功能,社交用户可以更高效、灵活地进行内容审查。第三,我们以微博为研究平台,将DeMod作为第三方工具实现,并招募35名参与者对DeMod的功能、效果、设计三个维度进行了综合的评估,结果表明DeMod在毒性内容审查方面表现出色,并获得参与者的高度认可。基于以上研究与结果,我们还提出了若干关于内容审查工具设计的见解,包括从全局视角增强审查工具设计、重视过程和结果可解释性、提供个性化改进措施,以帮助用户发布更合适的内容。

图1 DeMod框架设计

模型构造

1. 可解释检测器(Explainable Detector):实证研究表明,用户希望在毒性内容审查中获得细粒度的检测结果和解释性反馈。因此,我们设计了基于ChatGPT的可解释检测器。首先,该工具输出毒性检测结果,包括分类结果(是否含有毒性内容)以及相关的关键词。分类结果告知用户当前帖子是否包含毒性内容,如果是,工具会高亮显示引发毒性的关键词,以增强用户对毒性细节的感知。在此基础上,检测器提供即时和动态解释。即时解释说明帖子及关键词为何具有毒性;动态解释则通过利用ChatGPT的角色模拟能力预测受众对帖子的态度和意见,帮助用户了解内容可能产生的社会影响。这一设计契合基本人类价值理论,强调个体行为易受他人价值观的影响,包括他人的态度、个人信息等。为确保用户的自主性,DeMod允许用户手动选择受众角色,如父母、朋友甚至陌生人,并进行态度模拟。一旦选择了受众,DeMod便会模拟该角色对帖子的态度。上述检测及解释任务均基于ChatGPT模型实现。

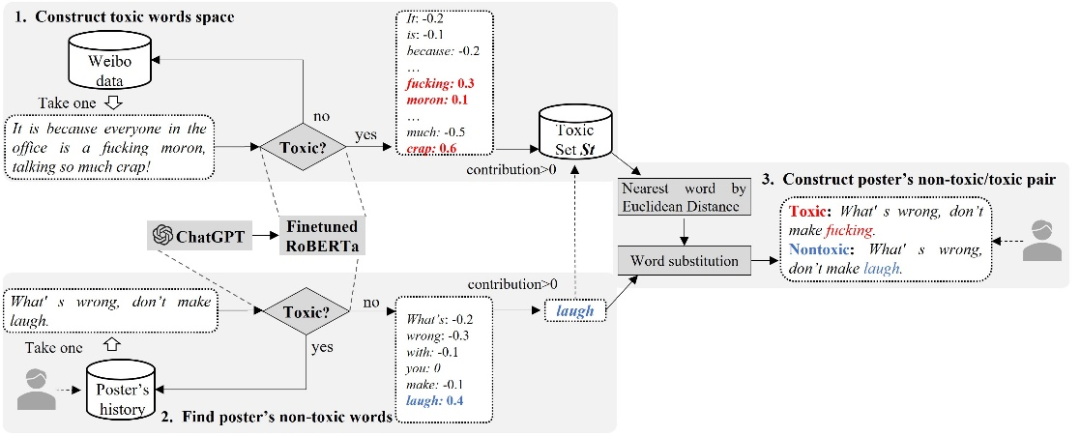

2. 个性化修改器(Personalized Modifier):实证研究表明,用户希望修改建议不仅能帮助他们去除帖子中的毒性内容,还能尽量保留原帖的语义和用户的个性化语言风格。我们发现,直接使用类似于检测任务的提示词让大模型执行毒性内容修改任务具有挑战性,很难同时实现这些多重目标。然而,大模型具备小样本学习能力,即Few-shot Learning。如果提供一些展示原始帖子(包含毒性内容)与相应修改后的内容(去除毒性但保留相似语义和用户语言风格)的示例对,大模型可以更好地实现这些修改目标。因此,我们通过构建毒性词空间、基于无毒样例构造毒性样例、无毒/毒性样例对翻转等步骤构建面向社交用户的个性化修改样例对,如图2所示,以此提升基于ChatGPT的个性化修改器的效果。

图2 个性化修改样例对构造过程

小结

本研究中,我们开发了DeMod,一个集成可解释检测与个性化修改功能的整体性毒性内容审查工具。通过提供多种解释和修改建议,DeMod减轻了社交用户的审查负担,并提升了他们的使用体验。广泛的评估表明,DeMod在功能丰富性、审查性能和易用性等方面具有多重优势。作为第一个研究整体性毒性内容审查的工作,DeMod也存在一些局限性。例如, DeMod目前仅支持文本模态的毒性内容审查以及仅在微博平台上进行评估验证,限制了对多模态内容以及不同社交平台的普遍性研究。因此未来,我们将专注于提升DeMod对多模态内容的审查能力,并拓展其在更多场景中的应用。

作者信息

如果您对本文内容感兴趣的话,可以与作者联系:

李亚琼 复旦大学计算机学院协同信息与系统实验室 博士研究生

研究方向:社交内容审核、CSCW、人机交互

联系方式:liyq22@m.fudan.edu.cn